Análisis factorial confirmatorio.pdf

-

Upload

mariopadilla -

Category

Documents

-

view

228 -

download

0

Transcript of Análisis factorial confirmatorio.pdf

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 1/55

Doctorado Interuniversitario en MarketingAnálisis de Datos Avanzado

ANÁLISIS FACTORIAL CONFIRMATORIO

Apuntes y ejercicios

Dr. Joaquin Aldas-Manzano

Departamento de Comercialización e Investigación de Mercados

Departament de Comercialització i Investigació de Mercats

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 2/55

2

Nota importante

Los presentes apuntes forman parte del borrador del libro de Joaquín

Aldás y Ezequiel Uriel Análisis Multivariante Aplicado que será

próximamente publicado por la editorial Thomson-Paraninfo. Por lo

tanto, como tal borrador pueden existir erratas, siendo bienvenidos todoslos comentarios que las detecten y sugerencias sobre la mejora del

capítulo.

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 3/55

3

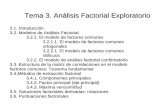

13 ECUACIONES ESTRUCTURALES:

ANÁLISIS FACTORIAL CONFIRMATORIO

13.1 INTRODUCCIÓN

El presente capítulo es el primero de los dos capítulos dedicados a ecuaciones estructurales.

Además de su interés en si mismo, facilita el tránsito al segundo capítulo dedicado a modelosde estructuras de covarianza. ¿Por qué el desarrollo del Análisis Factorial Confirmatorio

(AFC) facilita este tránsito? Básicamente por dos razones. En primer lugar, porque su

desarrollo se sigue con facilidad una vez el lector ha visto el capítulo dedicado al análisis

factorial exploratorio y, en segundo lugar, porque la herramienta estadística que lo resuelve

es, esencialmente, la misma que emplearemos en los modelos de estructuras de covarianza.

Muchos son los textos que el lector puede utilizar para profundizar en el análisis del AFC que,

en su gran mayoría, también incluyen el desarrollo de los modelos de estructuras de

covarianza. La elección de uno u otro suele ir ligada a la decisión acerca del programa

estadístico que se prefiera utilizar. El SPSS incluía, hasta hechas recientes, el programa

LISREL (Jöreskog y Sörbom, 1989) como módulo opcional, convirtiéndolo en el de uso más

extendido. Si se opta por este programa, Sharma (1996) ofrece una buena introducción con

salidas comentadas o, si se prefiere un texto con mayor profundidad, puede recurrirse a Long

(1983). Si, por el contrario, el lector opta por el EQS (Bentler, 1995), con un sistema de

notación mucho más intuitivo en nuestra opinión (Bentler y Weeks, 1980), una buena guía es,

sin duda, el texto de Byrne (1994). Una buena alternativa para aquellos que no se atreven a

decidirse por uno u otro tipo de software, es recurrir al módulo CALIS del SAS, que permite

utilizar alternativamente cualquiera de las dos notaciones. En este caso, Hatcher (1994) es un

buen texto. Finalmente, puede recurrirse a Ullman (1996) para una aproximación a esta

técnica con salidas comparadas de todos los programas mencionados.

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 4/55

4

Dado que, como hemos indicado, la notación de Jöreskog y Sörbon (1989) es la más

conocida, será la que utilizaremos en el desarrollo del tema. Sin embargo, llegado el

momento, presentaremos también la de Bentler y Weeks (1980) y demostraremos la

equivalencia de ambas.

Para introducirnos en el AFC es necesario presentar una serie de convenciones y términos noutilizados hasta el momento. Lo haremos basándonos en un ejemplo que nos servirá para ver

la diferencia entre el AFC y el análisis factorial exploratorio y los modelos de estructuras de

covarianza que analizaremos en el próximo tema.

CASO 13.1 Componentes de la inteligencia

Supongamos que un investigador ha recogido las notas de 275 alumnos de secundaria en seis

asignaturas: Lengua (L), Filosofía (FSF), Historia (H), Matemáticas (M), Física (FSC) y

Química (Q). En el cuadro 13.1 se recogen las correlaciones entre estas seis variables. Nuestro

investigador se plantea una cuestión a la que quiere dar respuesta. Asumiendo que las notas de

un alumno miden su inteligencia (I), desearía saber si estas se agrupan en un único factor (la

inteligencia) o, por el contrario, miden distintos aspectos de la misma, por ejemplo, lainteligencia cuantitativa (IQ) y la inteligencia verbal (IV).

Cuadro 13.1 Matriz de correlaciones entre las notas de los 275 estudiantes

L FSF H M FSC Q

X 1=L 1

X 2=FSF 0,493 1

X 3=H 0,401 0,314 1

X 4=M 0,278 0,347 0,147 1

X 5=FSC 0,317 0,318 0,183 0,587 1

X 6=Q 0,284 0,327 0,179 0,463 0,453 1

Si suponemos que el investigador no tiene una hipótesis a priori acerca de qué estructura es la

adecuada (un único componente de la inteligencia o dos), decidirá efectuar un análisis

factorial exploratorio para ver cuántos factores obtiene. Su planteamiento aparece recogido

gráficamente en la figura 13.1. Las variables observadas o manifiestas o indicadores, es decir,

aquellas que se han medido (las notas en los alumnos en nuestro ejemplo), aparecen insertadas

en un cuadrado y se denotan como X 1,..., X 6. Las variables latentes, esto es las no observables

o subyacentes (por ejemplo, los factores, como la inteligencia en general, o la inteligenciaverbal o cuantitativa en particular), aparecen rodeadas por círculos. Una flecha recta desde

una variable latente a una variable observada, indica una relación de causalidad. Así el factor

“ξ 1” está “causando” las notas de los alumnos en las seis asignaturas, es decir, la mayor o

menor inteligencia “cuantitativa” provoca que los alumnos tengan notas diferentes. El término

λ que aparece en cada una de las relaciones causales o “ paths” es el parámetro que mide la

intensidad de la relación, esto es, el término que denominamos “carga factorial” en una

análisis factorial exploratorio, o el coeficiente estandarizado asociado a una variable

independiente en una regresión múltiple.

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 5/55

5

Figura 13.1 Modelo de análisis factorial exploratorio

x1 x2 x3 x4 x5 x6

δ1 δ2 δ3 δ4 δ5 δ6

ξ1 ξ2

λ 11

λ 21 λ 31 λ 41λ 51

λ 61 λ 12

λ 22 λ 32 λ 42 λ 52

λ 62

φ12=φ21

Las variables latentes son de dos tipos. Los mencionados factores comunes (ξ ), que son

comunes en cuanto que sus efectos son compartidos por más de una variable observada, y los

factores específicos o errores (δ ). Como se comprueba en la figura 13.1, cada uno de estos

factores afecta solamente a una variable observada, y son errores aleatorios que se puedenhaber producido en la medida de la variable observada. Finalmente, la flecha curva con dos

puntas que une a los factores comunes, indica que estas variables están correlacionadas con

una intensidad φ 12.

Planteados los convenios de representación y los términos empleados en el AFC que son

comunes a los de los modelos de estructuras de covarianza, que se examinarán en el próximo

tema, nos restaría por señalar las diferencias del análisis factorial confirmatorio con respecto

al análisis factorial exploratorio, examinado en el tema 12, o con respecto al modelo de

estructuras de covarianza.

Volviendo a nuestro ejemplo, el investigador quiere saber si las notas están midiendo un

único componente de la inteligencia o, por el contrario, reflejan el efecto de varios

componentes. Como él no tiene establecida una hipótesis a priori, su análisis factorial ha de

contemplar como plausibles todas las posibilidades. Un caso extremo consistiría en que todas

las variables carguen de forma significativa sobre un solo factor. Un caso intermedio, aunque

puede haber otras muchas combinaciones, consistiría en que un grupo de variables cargue

significativamente sobre un factor y el resto de variables lo haga sobre un segundo factor. La

figura 13.1 recoge todas las posibilidades y, en concreto, estos dos casos. En el primer caso,

λ 11, λ 21, ... , λ 61 serían significativos, mientras que λ 12, λ 22, ... , λ 62 no lo serían. En el segundo

caso, λ 11, λ 21 y λ 31 tendrían un valor significativo y λ 41, λ 51, λ 61 no (las notas en literatura,

filosofía e historia cargan sobre un factor, inteligencia verbal, y no sobre el otro); por otra parte, λ 12, λ 22, λ 32 tendrían un valor no significativo, mientras que λ 42, λ 52, λ 62 sí (las notas en

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 6/55

6

matemáticas, física y química cargan sobre un factor, la inteligencia cuantitativa). El

investigador debe efectuar un análisis factorial exploratorio con objeto de averiguar cuál de

las dos posibilidades (o cualquiera de las otras muchas que sugiere la figura 13.1) es más

verosímil de acuerdo con los datos.

Ahora bien, el investigador basándose en estudios previos o en una revisión de la literaturaexistente, puede considerar la hipótesis, por ejemplo, de que no existe una medida global de la

inteligencia sino dos tipos alternativos de la misma: inteligencia verbal (que explicaría las

calificaciones en lengua, filosofía e historia) e inteligencia cuantitativa (que explicaría las

obtenidas en matemáticas, física y química). Si éste es el caso, el análisis exploratorio ya no

tiene sentido, ya que el investigador lo que pretende es confirmar o no la verosimilitud de su

hipótesis. Su planteamiento aparece recogido ahora en la figura 13.2.

El investigador puede plantearse otra hipótesis alternativa según la cual, sí existe una sola

medida global de la inteligencia que, a su vez, causa la inteligencia verbal y la cualitativa

(figura 13.3). Su misión consistiría, ahora, en determinar cuál de los dos modelos es más

verosímil de acuerdo con los datos. En este segundo caso, ha establecido una relación decausalidad, no de correlación, entre una o más variables latentes. El modelo deja de ser un

AFC para convertirse en un modelo de estructuras de covarianza. Nótese en la figura 13.3

que, ahora, los factores ξ 1 y ξ 2 no son variables independientes (además de salir una flecha

causal de ellas, también la reciben), por lo que están sujetos a un error de predicción que se

denomina perturbación (disturbance) y que se suele denotar mediante la letra ζ . Los

coeficientes de estos path se designan con la letra β .

Figura 13.2 Modelo de AFC

x1 x2 x3 x4 x5 x6

δ1 δ2 δ3 δ4 δ5 δ6

ξ1 ξ2

λ 11

λ 21 λ 31λ 42

λ 52 λ 62

φ12=

φ21

θ12=θ21 θ32=θ23 θ45=θ54 θ56=θ65

θ13=θ31 θ46=θ64

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 7/55

7

Figura 13.3 Modelo de estructuras de covarianzas

x1 x2 x3 x4 x5 x6

δ1 δ2 δ3 δ4 δ5 δ6

ξ1 ξ2

λ 11

λ 21 λ 31 λ 42

λ 52 λ 62

ξ3

β13 β23

ζ1 ζ2

13.2 FORMALIZACIÓN MATEMÁTICA DEL AFC

A partir del problema de AFC ilustrado en la figura 13.2, presentaremos a continuación la

formalización del mismo siguiendo la notación de Jöreskog y Sörbom, (1989), tal y como la

ofrece Long (1983). La relación entre las variables observadas y las latentes de la figura 13.2,

pueden expresarse:

1 11 1 1

2 21 1 2

3 31 1 3

4 42 2 4

5 52 2 5

6 62 2 6

x

x

x

x

x

x

λ ξ δ

λ ξ δ

λ ξ δ

λ ξ δ

λ ξ δ

λ ξ δ

= +

= +

= +

= +

= +

= +

Si recurrimos a la notación matricial, la anterior expresión adoptaría la forma:

01 11 1

02 21 2

03 31 31

04 42 42

05 52 5

06 62 6

x

x

x

x

x

x

λ δ

λ δ

λ δ ξ

λ δ ξ

λ δ

λ δ

⎡ ⎤ ⎡ ⎤ ⎡ ⎤⎢ ⎥ ⎢ ⎥ ⎢ ⎥⎢ ⎥ ⎢ ⎥ ⎢ ⎥⎢ ⎥ ⎢ ⎥ ⎢ ⎥

⎡ ⎤⎢ ⎥ ⎢ ⎥ ⎢ ⎥= +⎢ ⎥⎢ ⎥ ⎢ ⎥ ⎢ ⎥⎣ ⎦⎢ ⎥ ⎢ ⎥ ⎢ ⎥

⎢ ⎥ ⎢ ⎥ ⎢ ⎥⎢ ⎥ ⎢ ⎥ ⎢ ⎥⎢ ⎥ ⎢ ⎥ ⎢ ⎥⎣ ⎦ ⎣ ⎦ ⎣ ⎦

o de manera compacta:

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 8/55

8

= +x Λ δ (13-1)

donde, en general, x es un vector q×1 que contiene las q variables observadas, es un vector

s ×1 que contiene los s factores comunes, Λ es una matriz q× s que contiene las cargas

factoriales de las variables latentes y δ es un vector q×1 de los factores específicos o errores.

Asumimos que el número de variables observadas será siempre mayor que el de factorescomunes, o lo que es lo mismo que q> s.

Tanto las variables latentes como las observadas de la expresión (13-1) vienen expresadas

como desviaciones sobre la media, con lo que la esperanza de cada vector es otro vector de

ceros:

E (x)=0; E ( )=0 y E (δ)=0.

Este desplazamiento respecto al origen, no afecta a las covarianzas entre las variables.

Si denotamos como Σ a la matriz de varianzas covarianzas entre las variables observadas

(vector x), de acuerdo con 13.1, resulta que:

( ) ( )( ) E E ⎡ ⎤′′= =⎣ ⎦

xx Λ + δ Λ + δ

Teniendo en cuenta que la traspuesta de una suma de matrices es la suma de las traspuestas y

que la traspuesta de un producto es el producto de las traspuestas en orden inverso, tenemos

que:

( )( )[ ] E ′ ′ ′= Λ + δ Λ + δ

y teniendo en cuenta la propiedad distributiva y calculando la esperanza:

[ ]

[ ] [ ] [ ] [ ]

E

E E E E

′ ′ ′ ′ ′ ′= + + +

′ ′ ′ ′ ′ ′= + + +

Σ Λ Λ Λ δ δ Λ δδ

Λ Λ Λ δ δ Λ δδ

Dado que la matriz Λ no contiene variables aleatorias, al ser constantes los parámetros

poblacionales, se tiene que:

[ ] [ ] [ ] [ ] E E E E ′ ′ ′ ′ ′ ′= + + +Λ Λ Λ δ δ Λ δδ (13-2)

Si hacemos

[ ]

[ ]

E

E

′=

′=

Φ

Θ δδ

y asumimos que δ y están incorrelacionados entre sí, la expresión (13-2) puede escribirse

del siguiente modo:

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 9/55

9

′ += ΛΦΛ Θ (13-3)

Es muy importante, para desarrollos posteriores, analizar el contenido de la expresión (13-3).

Así, en el primer miembro aparece una matriz que contiene q(q+1)/2 varianzas y covarianzas

distintas de las variables observadas1 . En el segundo miembro aparecen q× s cargas factoriales

(Λ), s( s+1)/2 varianzas y covarianzas entre los factores comunes (

) y q(q+1)/2 varianzas ycovarianzas entre los factores específicos (δ). Por lo tanto, la expresión (13-3) expresa los

q(q+1)/2 elementos distintos de Σ en función de [qs+ s( s+1)/2+q(q+1)/2] parámetros

desconocidos de las matrices Λ, Φ y Θ. Así pues, los parámetros que se deberán estimar

aparecen vinculados mediante la expresión (13-3) a los valores de las varianzas y covarianzas

poblacionales de las variables observadas.

En el ejemplo ilustrado en la figura 13.2 se introducen restricciones adicionales sobre las

cargas factoriales y se asume que δ 1, δ 2 y δ 3 están incorrelacionadas con δ 4, δ 5 y δ 6. Teniendo

en cuenta estas restricciones y dado que existen q=6 variables observadas y s=2 factores

comunes, las matrices que contienen los parámetros a estimar adoptarán la forma siguiente:

11 12 13

21 22 23

11 12 31 32 33

12 22 44 45 46

54 55 56

64 65 66

011 0 0 00 0 0 021

0 0 0 031; ;

0 0 0 0420 0 00 520 0 00 62

λ θ θ θ

λ θ θ θ

λ φ φ θ θ θ

λ φ φ θ θ θ

θ θ θ λ

θ θ θ λ

⎡ ⎤⎡ ⎤⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥⎡ ⎤⎢ ⎥= = = ⎢ ⎥⎢ ⎥⎢ ⎥ ⎣ ⎦ ⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥ ⎢ ⎥⎣ ⎦⎢ ⎥⎣ ⎦

Λ Φ Θ

donde los subrayados indican que esos elementos de las matricesΛ

yΘ

son 0 por laespecificación concreta que tiene el modelo que se quiere contrastar. Lógicamente, si el

investigador asumiera otras hipótesis la configuración de estas matrices sería distinta. De

hecho, tal como hemos comentado anteriormente, en general, la matriz Θ tiene 6(6+1)/2 = 21

elementos distintos a estimar (el triángulo inferior), mientras que en nuestro caso, dado el

modelo especificado, sólo hay 12.

¿A qué se reduce, a grandes rasgos, el método AFC? La finalidad de este método es obtener

estimaciones de las matrices Λ, Φ y Θ que hagan que la matriz de varianzas y covarianzas

poblacional estimada Σ obtenida a partir de ellas, sea lo más parecida posible a la matriz de

varianzas y covarianzas muestral que se obtiene a partir de los valores muestrales de las

variables observadas. Pero para poder entrar en el procedimiento de estimación, es necesarioabordar previamente el problema de la identificación que se plantea en el método AFC.

13.3 IDENTIFICACIÓN DEL MODELO EN EL AFC

En el epígrafe anterior, hemos visto que en el método AFC disponemos de una serie de datos

(las varianzas y covarianzas muestrales de las variables observadas) y con ellos hemos de

estimar una serie de parámetros (cargas factoriales, varianzas y covarianzas de los factores

comunes, y varianzas y covarianzas de los factores específicos o errores). Al igual que ocurre

1 Para determinar el número de varianzas y covarianzas distintas, téngase en cuenta que Σ es una matriz q × q simétrica

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 10/55

10

con un sistema de ecuaciones lineales, podemos disponer en principio de más ecuaciones que

incógnitas, del mismo número o de mayor número de incógnitas que ecuaciones. Pues bien, la

identificación del modelo en el AFC hace referencia, precisamente, a la cuestión de si los

parámetros del modelo pueden o no ser determinados de forma única.

En palabras de Long (1983), si se intenta estimar un modelo que no esté identificado, losresultados que se obtendrán serán estimaciones arbitrarias de los parámetros lo que

desembocará en interpretaciones carentes de sentido. En el apéndice A13.1 se demuestra

cómo, si no se imponen restricciones a los parámetros a estimar, necesariamente habrá un

número infinito de soluciones posibles para los mismos.

¿Qué tipo de restricciones pueden imponerse a los parámetros? Por ejemplo, si una carga

factorial λ ij de la matriz Λ se fija a 0, estaremos indicando que el factor ξ j no afecta

causalmente a la variable observada xi. Si fijamos a 0 el elemento φ ij de la matriz Φ,

estaremos señalando que los factores ξ i y ξ j están incorrelacionados. Si todos los elementos de

la matriz Φ fuera de la diagonal se fijan a 0, los factores serán ortogonales (como ocurre en el

análisis factorial exploratorio, por ejemplo). Restricciones similares se pueden imponer a los

elementos de la matriz Θ.

Long (1983) señala que existen una serie de condiciones para que el modelo esté identificado:

necesarias (si no se dan, el modelo no está identificado), suficientes (si se dan el modelo está

identificado, pero si no se dan no tiene porqué no estarlo) y necesarias y suficientes (si se dan

el modelo está identificado y si no se dan está no identificado). No hay acuerdo entre la

literatura acerca de si existen o no las condiciones necesarias y suficientes. Jöreskog y

Sörbom (1989) señalan que el análisis de la llamada matriz de información, construida a partir

de la matriz de varianzas y covarianzas de los estimadores de los parámetros, puede servir

para establecer si el modelo está identificado. Estos autores señalan que “si la matriz deinformación es definida positiva es casi seguro que el modelo está identificado. Por el

contrario, si la matriz de información es singular, el modelo no está identificado”. Las

cursivas son de Long (1983) y las introduce porque indica que, dado que los programas

existentes verifican esta condición, si no hacen advertencias acerca de problemas en esta

matriz, estaríamos ante un buen indicador de que el modelo está identificado pero, en su

opinión, aún siendo la matriz definida positiva es posible, aunque improbable, que el modelo

no esté identificado. Otros autores, como Hatcher (1994) y Ullman (1996) confían también en

las advertencias de los programas como indicadores de no identificación. En general, la

mayoría de textos optan por recomendar que se comprueben una serie de condiciones

necesarias que suelen demostrarse como lo suficientemente exigentes para garantizar la

identificación del modelo. Siguiendo a Hatcher (1994) y Ullman (1996), el investigadordebería centrarse en las siguientes tareas:

1.

Comparar el número de datos con el número de parámetros que han de estimarse. Los

datos son siempre las varianzas-covarianzas muestrales, y hemos visto que existen

q(q+1)/2. Como el número de parámetros a estimar es qs+[ s( s+1)/2]+[q(q+1)/2], el

modelo estará sin identificar si no se imponen, al menos, qs+[ s( s+1)/2] restricciones.

Decimos “al menos” porque sólo si hay más datos que parámetros, el modelo está

sobreidentificado (caso particular de identificación), lo que hace que, al existir grados

de libertad, será posible la aceptación o el rechazo del modelo.

2.

Establecer una escala para los factores comunes. Esto se consigue fijando la varianza

de cada factor común a 1 o el coeficiente de regresión (carga factorial) de una de lasvariables observadas que cargan sobre cada factor a 1. Si esto no se hace se produce el

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 11/55

11

denominado problema de indeterminación entre la varianza y las cargas factoriales, es

decir, es imposible distinguir entre los casos en los que un factor tiene una varianza

grande y las cargas son pequeñas y el caso en que las varianzas son pequeñas y las

cargas altas.

3. Asegurar la identificabilidad de la parte del modelo que contiene la relación entre las

variables observadas y los factores. Para ello debe analizarse el número de factores yel número de variables observadas que cargan sobre cada factor. Si solo hay un factor,

el modelo puede estar identificado si el factor tiene al menos tres variables con cargas

no nulas sobre él. Si hay dos o más factores, examínese el número de variables

observadas de cada factor. Si cada factor tiene tres o más variables que cargan sobre

él, el modelo puede estar identificado si los errores asociados con los indicadores no

están correlacionados entre sí, cada variable carga sólo sobre un factor y los factores

pueden covariar entre ellos. Si sólo hay dos indicadores por factor, el modelo puede

estar indentificado si los errores asociados con cada indicador no están

correlacionados, cada indicador carga sólo sobre un factor y ninguna de las

covarianzas entre los factores es igual a cero.

4.

Fijar arbitrariamente el coeficiente de regresión del término de error al valor 12.

La aplicación de las condiciones expuestas al modelo de la figura 13.2, que nos viene

sirviendo de ejemplo, se ilustran en figura 13.4.

Figura 13.4 Modelo de AFC identificado

x1 x2 x3 x4 x5 x6

δ1*

ξ1*

1=λ 11

λ 21=* λ 31=*

1=λ 42

λ 52=*

φ12=φ21=*

0=θ12=θ21 0=θ32=θ23 0=θ45=θ54 0=θ56=θ65

ξ2*

λ 62=*

1 1 1 1 1 1

δ2* δ3* δ4* δ5* δ6*

0=θ13=θ31 0=θ46=θ64

2

En el modelo (13-1), como puede verse, los coeficientes correspondientes al término de error (δ ) son 1. Sinembargo, en algunos programas de ordenador para tratamiento del AFC se permite fijar los coeficientes δ avalores distintos de 1.

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 12/55

12

En primer lugar, recordemos que disponemos para estimar el modelo señalado de

6(6+1)/2=21 datos, que se corresponden con las varianzas covarianzas de las variables

observadas. Tenemos que estimar, en principio, 6×2+(2×3/2)+(6×7/2)=36 parámetros. Estos

parámetros son 12 coeficientes de regresión (cargas factoriales), la varianza de los 2 factores

comunes, la covarianza entre ellos, 6 coeficientes de regresión entre las variables observadas

y los factores específicos, las 6 varianzas de los factores específicos y las 15 covarianzas entreesos factores específicos.

Veamos en qué medida las condiciones de determinación anteriores influyen en esta situación.

En primer lugar, resolvemos el problema del establecimiento de la escala de los factores

comunes. Obsérvese en la figura 13.4 como se ha fijado a 1 el coeficiente de regresión entre la

variable x1 y el primer factor y ente la variable x4 y el segundo factor. Como indicábamos

podríamos haber fijado a 1 la varianza de ambos factores y dejar libres los mencionados

parámetros. Nótese que hemos señalado con un ‘*’ aquellos parámetros que sigue siendo

necesario estimar tras la identificación del modelo.

A continuación aseguramos la identificabilidad de la parte del modelo que contiene la relación

ente las variables observadas y los factores. En nuestro caso tenemos dos factores y tres

variables observadas sobre cada uno de ellos. Entonces, tal como señalamos con anterioridad,

se han adoptado los supuestos de que los errores asociados con los indicadores (δ ) no estan

correlacionados entre sí (es decir, las covarianzas θ ij se han hecho 0, como se observa en la

figura 13.4), y de que cada variable carga sólo sobre un factor. Por otra parte, sí se ha

permitido que las covarianzas entre los factores sean no nulas (las φ ij están marcadas con *

para ser estimadas).

Finalmente, los coeficientes de regresión entre las variables observadas y los términos de

error se han fijado arbitrariamente a 1.

Tras haber efectuado estas restricciones, cabe preguntarse ¿el modelo está identificado, o

sobreidentificado, y, en consecuencia, puede ser sometido a contraste? En otras palabras,

¿hay más datos que parámetros a estimar? O, análogamente, ¿disponemos de grados de

libertad suficientes? Los datos son, según hemos visto, 21, mientras que los parámetros a

estimar son los siguientes:

• 1 covarianza entre los factores comunes

•

2 varianzas de los factores comunes• 4 coeficientes de regresión entre las variables observadas y los factores comunes.

• 6 varianzas de los factores específicos (errores).

Es decir, hay 13 parámetros a estimar, con lo que tenemos 8 grados de libertad, dado que el

número de datos es 21. Por tanto, el modelo puede someterse a contraste. A continuación

aprovecharemos el ejemplo para presentar la sintaxis que nos permite estimarlo mediante uno

de los programas que indicábamos al comienzo del capítulo, concretamente, el EQS.

El EQS se basa en la notación de Bentler y Weeks (1980) que se limita a distinguir entre

variables dependientes e independientes en el AFC. Una variable será independiente cuando

de ella sólo salga una flecha causal y será dependiente si recibe alguna. Este programa denota

como V i a las variables observadas, como F i a los factores comunes y como E i a los factores

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 13/55

13

específicos. Si un parámetro se ha de estimar, aparece señalado con un asterisco en la

ecuación correspondiente y si se ha fijado que toma un valor determinado, se indica

expresamente. Las covarianzas, de no especificarse, se suponen que son nulas.

El cuadro 13.2 muestra la sintaxis del EQS para estimar el modelo de AFC, tal y como se ha

especificado en la figura 13.4.

Cuadro 13.2 Sintaxis de EQS para el problema de AFC

Bajo el apartado de /SPECIFICATIONS se refleja la siguiente información: el número de

casos, (CASE=275, tal y como se indicó en el cuadro 13.1 que recogía los datos originales);

numero de variables observadas (VAR=6); la selección de máxima verosimilitud como

método de estimación3 (ME=ML); indicación de que la matriz de datos suministrada es una

matriz de correlaciones (MA=COR); e indicación de que el análisis se efectúe sobre la matriz

de varianzas covarianzas (ANAL=COV). Estas dos últimas instrucciones tienen dos

implicaciones: en primer lugar, es necesario suministrar al programa la matriz de

3 En el epígrafe siguiente se examinarán los métodos de estimación

/TITLE

CFA INTELIGENCIA VERBAL Y CUANTITATIVA

/SPECIFICATIONS

CASE=275; VAR=6; ME=ML; MA=COR; ANAL=COV;

/MATRIX

1.000

0.493 1.000

0.401 0.314 1.000

0.278 0.347 0.147 1.000

0.317 0.318 0.183 0.587 1.000

0.284 0.327 0.179 0.463 0.453 1.000

/STANDARD DEVIATIONS

1.0900 0.5900 0.9800 1.1000 0.4100 1.1100

/LABELS

V1=L; V2=FSF; V3=H; V4=M; V5=FSC; V6=Q;

F1=IV; F2=IQ;

/EQUATIONS

V1= F1+E1;

V2=*F1+E2;

V3=*F1+E3;

V4= F2+E4;

V5=*F2+E5;V6=*F2+E6;

/VARIANCES

F1 TO F2=*;

E1 TO E6=*;

EFFECT=YES;

FIT=ALL;

/COVARIANCES

F1 TO F2=*;

/LMTEST

/WTEST

/END

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 14/55

14

correlaciones, lo que se hace bajo el apartado /MATRIZ y, en segundo lugar, para que el EQS

realice el análisis en términos de matriz de varianzas covarianzas es necesario ofrecerle las

desviaciones típicas de las variables observadas (/STANDARD DEVIATIONS).

El planteamiento de las ecuaciones se hace en el apartado /EQUATIONS. Puede comprobarse

que las variables observadas son dependientes siendo explicadas por los factores comunes ( F i)y por los específicos ( E i). Así, la primera ecuación:

V1=F1+E1

La anterior ecuación recoge la particularidad de que el parámetro de F1 (ξ 1, en la notación

anterior) es 1, porque se ha fijado a este valor tal y como se ve en la figura 13.4 (λ 11=1) y lo

mismo ocurre con el parámetro del término de error E1. En cambio, en la segunda ecuación:

V2=*F1+E2

el coeficiente del término de error sigue estando fijado a 1, pero es necesario estimar el parámetro de F1 (λ 21=*).

Todas las varianzas, tanto de los factores específicos como de los comunes han de estimarse,

tal como indica la instrucción /VARIANCES y lo mismo ocurre con las covarianzas ente los

factores comunes F1 y F2 (así lo indica la instrucción / COVARIANCES). Así pues, queda

comprobada la sencillez de la sintaxis del programa cuando seguimos la notación de Bentler y

Weeks (1980), dado que todo se reduce a distinguir entre variables dependientes e

independientes, lo que permite deducir de manera natural las ecuaciones. Las dos últimas

instrucciones (/LMTEST y /WTEST) las analizaremos más adelante. En el epígrafe siguiente,

que dedicamos a la estimación del modelo, comentaremos las salidas resultantes de la

ejecución del programa EQS con la sintaxis anterior.

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 15/55

15

13.4 ESTIMACIÓN DE MODELOS EN EL AFC

A partir de lo descrito, y siguiendo a Sharma (1996), el proceso de estimación del AFC puede

sintetizarse en los dos pasos siguientes:

•

1) Dada la matriz de varianzas covarianzas muestrales (S), se estiman los parámetrosdel modelo factorial hipotetizado.

• 2) Se determina el ajuste del modelo hipotetizado. Esto es, se determina en qué

medida la matriz de varianzas covarianzas estimada ( ˆ ) está próxima a la matriz de

varianzas covarianzas muestral S.

Presentaremos a continuación algunos de los métodos de estimación disponibles. Profundizar

en todos ellos va más allá del alcance de este libro, y recomendamos recurrir a Bentler (1995)

para ello. Sin embargo, se ofrecerán los fundamentos básicos de cada uno de ellos.

Como hemos señalado, el investigador parte de una matriz de varianzas y covarianzas

muestral S. Como ya se ha indicado, la matriz de varianzas y covarianzas poblacional

Σ, condicionada al modelo (13-1), está relacionada con los parámetros poblacionales por la

conocida expresión (13-3):

′= +ΛΦΛ Θ

Estimar el modelo, supone encontrar valores, a partir de los datos muestrales, para las

matrices anteriores (que denotamos con “^”) que cumplan las restricciones impuestas en el

proceso de identificación y que hagan que la matriz de varianzas y covarianzas estimada

mediante la expresión siguiente, sea lo más parecida posible a S:

ˆ ˆ ˆˆ ˆ ′= +ΛΦΛ Θ (13-4)

Long (1983) ilustra el proceso de estimación como sigue. Inicialmente existirán infinitas

matrices estimadas de Λ, Φ y Θ que satisfagan la expresión anterior, pero habrá que rechazar

todas aquellas soluciones que no cumplan las restricciones que se han impuesto en la

identificación del modelo. Llamemos genéricamente Λ

*, Φ

* y Θ

* a las matrices que sí

cumplen las restricciones. Esas matrices permiten obtener una estimación de la matriz de

varianzas covarianzas poblacional Σ* mediante (13-4). Si esta última matriz está próxima a S,

entonces las estimaciones de los parámetros contenidas en Λ

*, Φ

* y Θ

* serían razonables en el

sentido de ser consistentes con los datos de S.

Necesitamos una función, a la que denominamos una función de ajuste, que nos indique en

qué medida “Σ

* está próxima a S”. Long (1983) denota a estas funciones de ajuste con la

expresión F (S;Σ*) y están definidas para todas las matrices que cumplen las restricciones

marcadas en la identificación del modelo. Si entre dos matrices que cumplen esta condición se

verifica que F (S; 1∗

Σ

) < F (S; 2∗

Σ

), entonces concluiremos que 1∗

Σ está más “próxima” a S que

2∗

Σ . Consecuentemente, aquellos valores de Λ

*, Φ

* y Θ

* que minimizan el valor de F(S;Σ*)

serán las estimaciones de los parámetros poblacionales finales ˆ ˆ ˆy, Θ Φ .

Los procedimientos de estimación que vamos a describir a continuación son los siguientes:

mínimos cuadrados no ponderados, mínimos cuadrados generalizados, máxima verosimilitud,

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 16/55

16

estimación por la teoría de la distribución elíptica y estimación con libre distribución

asintótica.

13.4.1 Estimación por mínimos cuadrados no ponderados

La estimación por mínimos cuadrados no ponderados ULS (Unweighted Least Squares) tomacomo estimadores a los valores que minimizan la siguiente función de ajuste:

( ) ( )2*1

2ULS F tr ⎡ ⎤= −

⎣ ⎦SΣ;Σ Σ (13-5)

donde por tr indicamos la traza de la matriz resultante de la operación subsiguiente, esto es, la

suma de los elementos de su diagonal. Long (1983) y Ullman (1996) indican que este método

tiene dos limitaciones que hacen que no sea muy utilizado. En primer lugar, no existen

contrastes estadísticos asociados a este tipo de estimación y, en segundo lugar, los

estimadores dependen de la escala de medida de las variables observadas, esto es, no se

alcanzaría el mismo mínimo de (13-5) si las unidades del nivel de renta, por ejemplo,estuviera medida en pesetas que si lo estuviera en millones.

Este método tiene, sin embargo, algunas ventajas. Así, no es necesario asumir ningún tipo de

distribución teórica de las variables observadas, frente a la hipótesis de normalidad

multivariante que asumen otros métodos de estimación. Por ello, si la violación de esta

hipótesis fuera muy evidente, algunos autores recomiendan recurrir a la estimación por este

método, pero tomando como datos de partida la matriz de varianzas covarianzas estandarizada

– o matriz de correlaciones - para corregir el problema de la dependencia de las unidades de

medida.

13.4.2 Estimación por mínimos cuadrados generalizados

La estimación por mínimos cuadrados generalizados GLS (Generalized Least Squares) se

basa en ponderar la matriz cuya traza se calcula en (13-5) mediante la inversa de matriz de

varianzas covarianzas muestral, esto es:

( ) ( )2* * 11

;2

GLS F tr −⎡ ⎤= −⎣ ⎦S S SΣ (13-6)

13.4.3 Estimación por máxima verosimilitud

La estimación por máxima verosimilitud ML ( Maximum Likelihood ) implica minimizar la

siguiente función de ajuste:

( ) ( )* * 1 *; log log ML F tr q− ⎡ ⎤= + − −⎣ ⎦S S SΣ Σ (13-7)

donde toda la notación es conocida, salvo q que es el número de variables observadas y elhecho de denotar como | | al determinante de la matriz de referencia. Como señala Long

(1983) cuanto más se aproximen las matrices S yΣ

*

, más se aproximará el producto SΣ

*−1

a lamatriz identidad q×q. Como la traza de esa matriz identidad es la suma de los q unos de la

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 17/55

17

diagonal (o sea, q), el primer término de (13-7) se aproximará a q cuando las matrices estén

próximas, compensándose con el término q de (13-7). Por otra parte, la diferencia de los

logaritmos de los determinantes de S y Σ

*tenderá a 0, dado que, cuando las matrices estén

próximas, también lo estarán sus determinantes. De esta forma, cuando las matrices sean

iguales la función de ajuste será cero.

13.4.4 Estimación por la teoría de la distribución elíptica

La estimación EDT ( Elliptical Distribution Theory) se basa en la distribución de probabilidadde este nombre. La distribución normal multivariante es un caso particular de esta familia con parámetro de curtosis4 igual a cero. En este caso, la función a minimizar adopta la forma:

( ) ( ) ( ) ( )2 21* * 1 * 11

; 12

EDT F tr tr κ δ − − −⎡ ⎤ ⎡ ⎤Σ = + − Σ − − Σ⎣ ⎦ ⎣ ⎦S S W S W (13-8)

siendo κ y δ funciones de curtosis y W cualquier estimador consistente de Σ.

13.4.5 Estimación con libre distribución asintótica

La estimación ADF ( Asymptotically Distribution Free) minimiza una función definida

mediante la siguiente expresión:

( ) ( )[ ] ( )[ ]* 1; ADF F σ σ −′= − −S s W sΘ Θ (13-9)

donde s es el vector de datos, es decir, la matriz de varianzas covarianzas muestrales pero

escrita en forma de un solo vector; σ es el la matriz de varianzas covarianzas estimada, de

nuevo puesta en forma de vector y donde con el término (Θ) se ha querido indicar que sederiva de los parámetros del modelo (coeficientes de regresión, varianzas y covarianzas). W

es una matriz que pondera las diferencias cuadráticas entre las matrices de varianzas y

covarianzas muestrales y estimadas. En este caso, cada elemento de esa matriz se obtiene:

ijkl ijkl ij kl w σ σ σ = −

siendo σ ijkl momentos de 4º orden y σ ij y σ kl las covarianzas.

13.4.6 Comparación de los distintos procedimientos de estimación

Resumimos a continuación los resultados del trabajo de Hu, Bentler y Kano (1992), que

analizaron mediante simulación de Monte Carlo cómo se comportaban los distintos

procedimientos de estimación ante distintos tamaños muestrales, violación de las hipótesis denormalidad y de independencia entre los términos de error y los factores comunes.

Estos autores encontraron que, en caso de que fuera razonable asumir la normalidad, el

método ML funcionaba mejor cuando el tamaño muestral era superior a 500, mientras que

4 El coeficiente de curtosis de una distribución es igual al coeficiente estandarizado de cuarto orden menos 3.

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 18/55

18

para tamaños inferiores a esa cifra tenía un mejor comportamiento el método EDT.

Finalmente, el método ADF sólo ofrecía buenos resultados con muestras superiores a 2500

casos.

Cuando el supuesto de normalidad se violaba, los métodos de ML y GLS solo daban buenos

resultados con muestras superiores a 2500 casos, aunque el GLS funcionaba algo mejor que elML en muestras inferiores. Pese a no adoptar el supuesto de normalidad, el método ADFtampoco daba buenos resultados con muestras inferiores a 2500 casos.

Cuando se produce una violación del supuesto de independencia entre los términos de error y

los factores comunes, los métodos de ML y GLS funcionan muy mal, y también el ADF salvoque la muestra fuera superior a 2500 casos. En cambio, el EDT funcionaba significativamente

mejor que los demás.

A la luz de lo expuesto, Ullman (1996) recomienda:

•

Los métodos de ML y GLS son la mejor opción con pequeñas muestras siempre quesea plausible la asunción de normalidad e independencia.

• En el caso en que ambos supuestos no parezcan razonables, se recomienda recurrir a laestimación ML denominada “escalada”. Una descripción de este procedimiento se

encuentra en Bentler (1980) y es una opción de estimación del EQS.

Veamos, a modo de ilustración, el resultado de estimar mediante máxima verosimilitud las

matrices de (13-4). Para facilitar la familiarización con el EQS se ha seleccionado la parte deloutput resultante de aplicar la sintaxis recogida en el cuadro 13.2 que contiene esta

información.

En primer lugar, el programa ofrece la matriz S de varianzas covarianzas muestrales (cuadro

13.3). Como se señaló al comentar la sintaxis, al programa se le ha suministrado una matriz decorrelaciones y las desviaciones típicas de las variables observadas. A partir de esta

información el programa calcula la matriz de varianzas covarianzas muestral.

Cuadro 13.3 Matriz S de varianzas covarianzas muestrales

La matriz Λ, que contiene los coeficientes de regresión entre las variables observadas y losfactores comunes, se obtiene directamente de las ecuaciones que el EQS denomina ecuacionesde medida y que se recogen en el cuadro 13.4. En estas ecuaciones aparecen también losestadísticos para contrastes de significatividad de cada coeficiente, así como los errores

estándar, cuya interpretación se ofrecerá más adelante.

L FSF H M FSC Q

V 1 V 2 V 3 V 4 V 5 V 6

L V 1 1.188

FSF V 2 0.317 0.348

H V 3 0.428 0.182 0.960

M V 4 0.333 0.225 0.158 1.210

FSC V 5 0.142 0.077 0.074 0.265 0.168

Q V 6 0.344 0.214 0.195 0.565 0.206 1.232

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 19/55

19

De este cuadro se deduce directamente que la estimación de Λ es la siguiente5:

1 0

0,509 0

0,604 0ˆ0 1

0 0,373

0 0,817

⎡ ⎤⎢ ⎥⎢ ⎥⎢ ⎥

= ⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥⎣ ⎦

Λ

Cuadro 13.4 Matriz Λ de coeficientes de regresión

La estimación de Φ (matriz de varianzas covarianzas de los factores comunes) aparece

separada en dos elementos de la salida del EQS (ambas recogidas en el cuadro 13.5):

“varianzas entre las variables independientes” y “covarianzas entre las variables

independientes”. De esta salida se obtiene que la estimación de la mencionada matriz es:

0,636 0,388ˆ0,388 0,698

⎡ ⎤= ⎢ ⎥⎣ ⎦

Cuadro 13.5 Matriz Φ estimada de varianzas covarianzas entre factores comunes

5 Los subrayados indican que ese parámetro se fijo al valor señalado durante la identificación del modelo.

MEASUREMENT EQUATIONS WITH STANDARD ERRORS AND TEST STATISTICS

L =V1 = 1.000 F1 + 1.000 E1

FSF =V2 = .509*F1 + 1.000 E2.068

7.467

H =V3 = .604*F1 + 1.000 E3

.096

6.319

M =V4 = 1.000 F2 + 1.000 E4

FSC =V5 = .373*F2 + 1.000 E5

.039

9.467

Q =V6 = .817*F2 + 1.000 E6.096

8.552

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 20/55

20

Finalmente resta por obtener la estimación de la matriz Θ, que contiene las varianzas y

covarianzas entre los factores específicos o términos de error. Si se observa la figura 13.4, se

comprueba que, durante la identificación del modelo, todas las covarianzas se fijaron a 0

(como se indica con un subrayado en la matriz que se muestra a continuación), por lo que sólo

se han estimado las varianzas. El cuadro 13.6 ofrece la información que nos permite obtener

la estimación de la matriz Θ:

0,552 0 0 0 0 0

0 0,183 0 0 0 0

0 0 0,728 0 0 0ˆ

0 0 0 0,512 0 0

0 0 0 0 0,071 0

0 0 0 0 0 0,767

⎡ ⎤

⎢ ⎥⎢ ⎥⎢ ⎥

= ⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥⎣ ⎦

Θ

Basta operar matricialmente de acuerdo con la expresión (13-4) para obtener la estimación de

la matriz de varianzas covarianzas poblacional (el EQS no la ofrece):

1,188

0,324 0,348

0, 384 0,196 0, 960ˆ

0, 388 0,197 0, 234 1, 210

0,145 0, 074 0, 087 0, 260 0,168

0,317 0,161 0,191 0,570 0, 213 1, 232

⎡ ⎤⎢ ⎥⎢ ⎥⎢ ⎥

= ⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥⎢ ⎥⎣ ⎦

Σ (13-10)

VARIANCES OF INDEPENDENT VARIABLES

----------------------------------

V F

--- ---

I F1 - IV .636*I

I .117 I

I 5.443 II I

I F2 - IQ .698*I

I .112 I

I 6.244 I

I I

COVARIANCES AMONG INDEPENDENT VARIABLES

---------------------------------------

V F

--- ---

I F2 - IQ .388*I

I F1 - IV .068 I

I 5.712 I

I I

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 21/55

21

Cuadro 13.6 Matriz Θ estimada de varianzas covarianzas entre factores específicos

La diferencia entre la matriz de varianzas covarianzas muestral S y la matriz de varianzas y

covarianzas poblacional estimada recogida en (13-10) es la denominada matriz residual de

covarianzas. Esta matriz nos indica en qué medida el modelo ha sido capaz de ajustarse a los

datos. Para que el ajuste sea bueno, los valores de cada uno de sus elementos deben ser pequeños. El EQS ofrece esta matriz tal y como la recogemos en el cuadro 13.7.

Cuadro 13.7 Matriz residual de varianzas covarianzas

13.5 BONDAD DE AJUSTE DEL MODELO ESTIMADO

Antes de pasar a interpretar los resultados del análisis factorial confirmatorio que se ha

efectuado, es necesario determinar hasta qué punto el modelo asumido se ajusta a los datosmuestrales. Si detectáramos problemas de ajuste, sería necesario plantear algún tipo de

VARIANCES OF INDEPENDENT VARIABLES

----------------------------------

E D

--- ---

E1 - L .552*I I

.088 I I6.256 I I

I I

E2 - FSF .183*I I

.025 I I

7.294 I I

I I

E3 - H .728*I I

.071 I I

10.281 I I

I I

E4 - M .512*I I

.075 I I

6.828 I I

I I

E5 - FSC .071*I I

.010 I I6.807 I I

I I

E6 - Q .767*I I

.079 I I

9.655 I I

I I

RESIDUAL COVARIANCE MATRIX (S-SIGMA) :

L FSF H M FSC Q

V 1 V 2 V 3 V 4 V 5 V 6

L V 1 0.000

FSF V 2 -0.007 0.000

H V 3 0.044 -0.014 0.000

M V 4 -0.055 0.028 -0.076 0.000

FSC V 5 -0.003 0.003 -0.014 0.004 0.000

Q V 6 0.027 0.053 0.003 -0.005 -0.006 0.000

AVERAGE ABSOLUTE COVARIANCE RESIDUALS =

0.0163

AVERAGE OFF-DIAGONAL ABSOLUTE COVARIANCE RESIDUALS = 0.0228

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 22/55

22

reespecificación del mismo hasta que se lograra un mejor ajuste. Analizaremos, a

continuación, una serie de criterios que se calculan en la mayor parte de programas que

abordan este tema. Como ya avanzamos, los estadísticos elaborados con esta finalidad son

muchos más de que los que aquí se muestran. La selección efectuada recoge, desde nuestro

punto de vista, los más utilizados.

13.5.1 Matriz residual de covarianzas

Como indicábamos al presentar los distintos métodos de estimación del AFC, el objetivo

básico de los mismos es que la matriz de covarianzas poblacional estimada se parezca lo más

posible a la muestral S. En otros términos, puede expresarse lo anterior diciendo que la

diferencia entre ambas matrices, a la que llamamos matriz residual de covarianzas, esté lo más

cercana posible a una matriz nula 0. Los valores de esta matriz deberían ser pequeños y estar

homogéneamente distribuidos. Como señala Byrne (1994), residuos grandes asociados a

algunos parámetros, podrían indicar que han sido mál especificados, y ello afectaría

negativamente al ajuste global del modelo. El EQS proporciona la matriz residual de

covarianzas recogida en el cuadro 13.7, así como su versión estandarizada que mostramos enel cuadro 13.8. En ambos casos calcula los promedios de estos residuos teniendo en cuenta los

elementos de la diagonal y obviándolos. Este segundo promedio se justifica porque,

normalmente, son los elementos de fuera de la diagonal los que tienen más influencia sobre el

estadístico χ 2 que mostraremos más adelante (Bentler, 1995).

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 23/55

23

Cuadro 13.8 Matriz residual estandarizada de varianzas covarianzas y otra información relacionada

Asimismo, el programa ordena de mayor a menor los 20 residuos estandarizados más grandes

en valor absoluto, de tal manera que puedan identificarse las variables con mayores errores.

Finalmente, muestra un gráfico con la distribución de estos residuos, distribución que debería

ser simétrica y centrada en cero.

Examinando los resultados de nuestro ejemplo en concreto, observamos que el error promedio

de los elementos fuera de la diagonal es pequeño (0.0282), indicando un buen ajuste. El

elemento que muestra un mayor residuo es el asociado a las variables V2 y V6 (notas en

química y filosofía), pudiendo indicar una mala especificación, lo que será analizado

posteriormente para comprobar si procede su reespecificación. Finalmente comprobamos que

STANDARDIZED RESIDUAL MATRIX:

L FSF H M FSC Q

V 1 V 2 V 3 V 4 V 5 V 6

L V 1 0.000

FSF V 2 -0.011 0.000

H V 3 0.041 -0.024 0.000

M V 4 -0.046 0.043 -0.070 0.000

FSC V 5 -0.007 0.013 -0.035 0.010 0.000

Q V 6 0.022 0.081 0.003 -0.004 -0.014 0.000

AVERAGE ABSOLUTE STANDARDIZED RESIDUALS = 0.0201

AVERAGE OFF-DIAGONAL ABSOLUTE STANDARDIZED RESIDUALS = 0.0282

LARGEST STANDARDIZED RESIDUALS:

V 6,V 2 V 4,V 3 V 4,V 1 V 4,V 2 V 3,V 1

0.081 -0.070 -0.046 0.043 0.041

V 5,V 3 V 3,V 2 V 6,V 1 V 6,V 5 V 5,V 2-0.035 -0.024 0.022 -0.014 0.013

V 2,V 1 V 5,V 4 V 5,V 1 V 6,V 4 V 6,V 3

-0.011 0.010 -0.007 -0.004 0.003

V 2,V 2 V 3,V 3 V 6,V 6 V 5,V 5 V 4,V 4

0.000 0.000 0.000 0.000 0.000

DISTRIBUTION OF STANDARDIZED RESIDUALS

----------------------------------------

! !

20- -

! !

! !

! !! ! RANGE FREQ PERCENT

15- -

! ! 1 -0.5 - -- 0 0.00%

! ! 2 -0.4 - -0.5 0 0.00%

! ! 3 -0.3 - -0.4 0 0.00%

! * ! 4 -0.2 - -0.3 0 0.00%

10- * * - 5 -0.1 - -0.2 0 0.00%

! * * ! 6 0.0 - -0.1 11 52.38%

! * * ! 7 0.1 - 0.0 10 47.62%

! * * ! 8 0.2 - 0.1 0 0.00%

! * * ! 9 0.3 - 0.2 0 0.00%

5- * * - A 0.4 - 0.3 0 0.00%

! * * ! B 0.5 - 0.4 0 0.00%

! * * ! C ++ - 0.5 0 0.00%

! * * ! -------------------------------

! * * ! TOTAL 21 100.00%

----------------------------------------

1 2 3 4 5 6 7 8 9 A B C EACH "*" REPRESENTS 1 RESIDUALS

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 24/55

24

el 100% de los residuos cae dentro del intervalo [–0.1; 0.1] de forma prácticamente simétrica

y, como se ha señalado, centrada en cero. En síntesis, el ajuste del modelo, a partir del análisis

de los residuos es bueno, aunque puede existir un problema debido a la interrelación entre las

variables V2 y V6.

13.5.2 Estadísticos χ

2 para el contraste global del modelo

Como hemos visto anteriormente, se ha denominadoΣ

a la matriz de varianzas covarianzas

del vector x condicionado al modelo (13-1); su estimación se ha denotado por Σ̂ . Por otra

parte, vamos a denominar nc a la matriz de varianzas covarianzas de x no condicionada al

modelo; la estimación de esta matriz es directamente la matriz muestral S. En el caso de que

el modelo sea adecuado para explicar el comportamiento de x, ambas matrices serán iguales.

Por lo tanto, podemos establecer la siguiente hipótesis nula:

0 : nc H =Σ Σ (13-11)

La hipótesis alternativa postula que la matriz nc es igual a cualquier matriz que sea definida

positiva. Para el contraste de estas hipótesis en Bentler y Bonett (1980) se propone el

siguiente estadísico:

0

L N F ×

donde N es el número de datos y 0 L

F es el valor que toma la función de ajuste (13-7) al

realizar la estimación por máxima verosimilitud. Este estadístico se distribuye, bajo la

hipótesis nula, como una χ 2 con ½q(q+1)-k grados de libertad, siendo q el número de

variables independientes y k el número de parámetros a estimar. Si el modelo es el adecuado,

se puede esperar que se rechace la hipótesis nula planteada en este contraste. En el EQS a

este estadístico se le denomina Chi Square.

El EQS ofrece, además, un segundo estadístico denominado independence model chi-square.

Este estadístico se distribuye también como una χ 2 bajo la hipótesis nula de que existe una

completa independencia entre las variables (matriz de correlaciones identidad). En este caso,

si el modelo es el apropiado, cabe esperar que el estadístico tome valores elevados. Por elcontrario, si todas las variables observadas fueran independientes entre sí el modelo de AFC

propuesto no tendría sentido y, consecuentemente, este estadístico tomaría valores bajos.

El cuadro 13.9 recoge junto a los dos estadísticos citados, otros estadísticos que miden la

bondad del ajuste que comentaremos posteriormente. Por otra parte el estadístico χ 2 para este

modelo en que son independientes las variables observadas es efectivamente muy alto

(392,8). Por otra parte, el estadístico χ 2 para contrastar la hipótesis nula (13-11) tiene ½ 6

(6+1)-13 = 8 grados de libertad y toma el valor 8,84 con un p=0,355, lo que nos permite

aceptar la hipótesis nula de igualdad entre las matrices para los niveles usuales de

significación. Este estadístico se utiliza, en definitiva, para contrastar la validez del modelo

teórico propuesto por el investigador.

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 25/55

25

Cuadro 13.9 Estadísticos de bondad de ajuste

En la construcción del estadístico χ 2 se ha tenido en cuenta que (i) se asume la hipótesis de

normalidad de las variables observadas, (ii) el análisis se basa en una matriz de varianzas y

covarianzas y no en una matriz de correlaciones y (iii) el tamaño muestral es lo

suficientemente grande para que se justifiquen las propiedades asintóticas del contraste.

Ahora bien, dado que rara vez se cumplen simultáneamente estos requisitos, Bentler y Bonett

(1980), Long (1983) y Ullman (1996), entre otros, señalan que la utilización de este

estadístico debe efectuarse con precaución con muestras grandes, dado que incluso pequeñas

diferencias entre las matrices de covarianzas muestral y estimada serán evaluadas como

significativas por el contraste. Este limitación ha llevado al desarrollo de más de 30

indicadores ad hoc de bondad de ajuste (véase Marsh, Balla y McDonald, 1988; Tanaka,1993; Browne y Cudeck, 1993 o Williams y Holahan, 1994 para una revisión de los mismos),

algunos de los cuales se mostrarán a continuación.

13.5.2 Estadísticos ad hoc

Un primer grupo de estadísticos se correspondería con los denominados por Ullman (1996)

índices comparativos de ajuste. Los distintos modelos que se pueden plantear en un AFC van

desde el que hemos denominado modelo independiente (variables sin ninguna relación) y que

tendría tantos grados de libertad como el número de datos menos el de varianzas que se han

de estimar, hasta el llamado modelo saturado, con ningún grado de libertad. Los índices que

se proponen son comparativos en el sentido de que comparan el valor del modelo teórico quese evalúa, con el del modelo independiente.

Índice NFI

El índice NFI ( Normed Fit Index) ha sido propuesto por Bentler y Bonnett (1980) y compara

el valor del estadístico χ 2 del modelo teórico con el del modelo independiente:

2 2

2

indep teorico

indep

NFI χ χ

χ

−=

GOODNESS OF FIT SUMMARY

INDEPENDENCE MODEL CHI-SQUARE = 392.818 ON 15 DEGREES OF FREEDOM

INDEPENDENCE AIC = 362.81793 INDEPENDENCE CAIC = 293.56637

MODEL AIC = -7.15793 MODEL CAIC = -44.09210

CHI-SQUARE = 8.842 BASED ON 8 DEGREES OF FREEDOM

PROBABILITY VALUE FOR THE CHI-SQUARE STATISTIC IS 0.35579

THE NORMAL THEORY RLS CHI-SQUARE FOR THIS ML SOLUTION IS 9.157.

BENTLER-BONETT NORMED FIT INDEX= 0.977

BENTLER-BONETT NONNORMED FIT INDEX= 0.996

COMPARATIVE FIT INDEX (CFI) = 0.998

BOLLEN (IFI) FIT INDEX= 0.998

McDonald (MFI) FIT INDEX= 0.998

LISREL GFI FIT INDEX= 0.989

LISREL AGFI FIT INDEX= 0.971

ROOT MEAN SQUARED RESIDUAL (RMR) = 0.027

STANDARDIZED RMR = 0.044

ROOT MEAN SQ. ERROR OF APP.(RMSEA)= 0.020

90% CONFIDENCE INTERVAL OF RMSEA ( 0.000, 0.075)

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 26/55

26

Para que sea satisfactorio este estadístico, como la mayor parte de los que examinaremos a

continuación, debe alcanzar valores superiores a 0,90 (Bentler, 1992).

En nuestro ejemplo, como puede comprobarse en el cuadro 13.9, su valor es el siguiente:

392,81 8,84 0,977392,81

NFI −= =

Algunos trabajos han demostrado que este índice tiene una tendencia a subestimar el ajuste

del modelo si las muestras son pequeñas (Bearden, Sharma y Teel, 1982), llevando a sus

autores a plantear dos modificaciones del mismo, el índice NNFI y el CFI.

Índice NNFI

El Nonnormed Fit Index (NNFI) incorpora los grados de libertad de los modelos teórico e

independiente y aunque se evita así la subestimación del ajuste, puede provocar en algunos

casos extremos valores fuera del rango 0-1. Otra limitación es que, en pequeñas muestras,

puede indicar un ajuste excesivamente bajo si se compara con otros modelos, tal y como

apuntan Ullman (1996) y Anderson y Gerbing (1984).

2 2

2

indepindep teorico

teorico

indep indep

gl

gl NNFI

gl

χ χ

χ

−=

−

En el ejemplo que nos ocupa, y tomando la información del cuadro 13.9, este estadístico

ofrece también un buen ajuste:

15392,81 8,84

8 0,996392,81 15

NNFI −

= =−

Índice CFI

Este índice (Comparative Fit Index), propuesto por Bentler (1988), corrige por el número de

grados de libertad del siguiente modo:

( ) ( )( )

2 2

2

indep indep teorico teorico

indep indep

gl gl CFI

gl

χ χ

χ

− − −=

−

En nuestro ejemplo este índice también toma un valor satisfactorio:

( ) ( )

( )

392,81 15 8.84 80,998

392,81 15CFI

− − −= =

−

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 27/55

27

Índice IFI

Propuesto por Bollen (1989), pretende corregir la posibilidad de que el NNFI tome valores

por encima del intervalo razonable 0-1. Para ello se formula así:

2 2

2

indep teorico

indep teorico

IFI gl

χ χ

χ

−=

−

En nuestro ejemplo este índice también alcanza valores de ajuste razonables. A partir de la

información del cuadro 13.9, se obtiene el siguiente valor:

392,81 8,840,998

392,81 8 IFI

−= =

−

Índice MFI

Propuesto por McDonald y Marsh (1990), el índice MFI entraría en los denominados índices

de ajuste absoluto en contraposición a los anteriores que hemos denominado comparativos,

por basarse en poner en relación el modelo teórico con el independiente. El MFI solo toma en

consideración la χ 2 del modelo teórico y responde a la expresión siguiente:

21

2teorico teorico gl

N MFI e χ −

− ⋅=

donde toda la notación es conocida salvo N que indica el tamaño de la muestra. Con los datos

del cuadro 13.9 se comprueba que:

1 8,84 8

2 275 0,998 MFI e−

− ×= =

Índice GFI

Ullman (1996) denomina a este índice y al AGFI que, como se verá, es una sencilla

corrección de aquel, índices de proporción de varianza. El índice GFI (Goodness of Fit Index)

es una ratio entre los elementos ponderados de la matriz de covarianzas poblacional estimaday los elementos ponderados de la matriz de covarianzas muestral. Concretamente, su

expresión es la siguiente:

( )

( )

ˆ ˆ

ˆ ˆ

tr GFI

tr

′=

′

Ws Wsσ σ

donde el vector σ̂ contiene las varianzas de la matriz de covarianzas estimada y el vector s las

de la matriz muestral. La matriz W es una matriz de ponderación que varía en función delmétodo de estimación elegido: la matriz identidad en el ULS, la matriz de covarianzas

muestral en el GLS, la inversa de la matriz de covarianzas estimada en el ML, etcétera. Según puede verse en el cuadro 13.9, este estadístico toma el valor 0,981.

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 28/55

28

Índice AGFI

El Adjusted Goodness of Fit Index (AGFI) es una corrección del anterior que se hace en

función del número de parámetros que se han de estimar (a los que denominanmos k ) y el

número de datos disponibles (a los que denominamos d ). Esta corrección adopta la forma:

11

1

GFI AGFI

k d

−= −

−

En nuestro ejemplo, con la información del cuadro 13.9, y recordando que se disponía de 21datos y 13 parámetros a estimar, el valor del estadístico es el siguiente:

1 0,9891 0,971

131 21

AGFI −

= − =

−

Índice AIC

Este índice, denominado Akaike Information Criterion (Akaike, 1987) forma parte de unnuevo grupo que Ullman (1996) denomina índices de grado de parsimonia, por cuanto tienen

en cuenta no solamente la bondad de ajuste estadístico sino también el número de parámetrosa estimar. Su expresión adopta la forma:

2 2teorico teorico AIC gl χ = −

Para nuestro ejemplo, con la información del cuadro 4.9 se obtiene el siguiente valor:

8,84 2 8 7,15 AIC = − × = −

¿Qué valor debe tomar este índice? Ullman (1996) señala que “lo suficientemente bajo” pero,

dado que no está normalizado a un intervalo 0-1, “suficientemente bajo” solo puede

entenderse en términos comparativos con otros modelos teóricos, es decir, servirá comoindicador para señalar si el modelo que hemos contrastado es mejor o peor que otro modelocontrastado previamente, pero no ofrece un nivel de ajuste absoluto. Esta es la razón de que

siempre vaya acompañado por el AIC del modelo independiente, que se supone que es la baseque cualquier modelo teórico debe mejorar y cuanto mayor sea la diferencia del valor del AICdel modelo comparado con el valor correspondiente independiente, tanto mejor. En nuestro

ejemplo lo mejora muy claramente, dado que el AIC en el modelo independiente toma elvalor:

392,81 2 15 362,81 AIC = − × =

Índice CAIC

El Consistent AIC (CAIC) es la corrección propuesta por Bozdogan (1987) al AIC, siendo

válidos todos los comentarios efectuados para este último. Su expresión es la siguiente:

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 29/55

29

( )2 ln 1teorico teoricoCAIC N gl χ = − +

En nuestro ejemplo, como puede verse en el cuadro 13.9, toma el siguiente valor:

( )8,84 ln 275 1 8 44,09CAIC = − + = −

que debe compararse con el CAIC del modelo independiente:

( )392,81 ln 275 1 15 293,56CAIC = − + =

Índice RMR

El último grupo de índices que analizaremos son los que Ullman (1996) denomina basados enlos residuos que no son sino un promedio de las diferencias entre las varianzas y covarianzasmuestrales y las estimadas que se derivan del modelo. Esto es:

( )

( )

2

1 1

ˆ

1 / 2

q i

ij iji j

s

RMRq q

σ = =

−

=+

∑∑

donde toda la notación es conocida, pero recordemos que q era el número de variables

observadas. En nuestro ejemplo este índice toma el valor de 0.027.

Como los residuos sin estandarizar están afectados por la escala en que se mide la variable, se

suelen utilizar los residuos estandarizados construyéndose el llamado SRMR (Standardized

RMR) que está acotado entre 0 y 1, siendo recomendables valores inferiores a 0,05. Como puede verse en el cuadro 13.9, el índice SRMR se sitúa ligeramente por debajo de 0,05

(0,044).

13.5.3 Convergencia en el proceso de estimación

Byrne (1994) plantea que, en cuanto que la estimación del modelo es un proceso iterativo, elhecho de que el algoritmo converja de una manera rápida, es indicador de un buen ajuste delmodelo. La autora considera que, si después de dos o tres iteraciones, el cambio medio en las

estimaciones de los parámetros se estabiliza en valores muy bajos, estaremos probablemente

ante un ajuste adecuado.

El EQS ofrece (cuadro 13.10) la información del número de iteraciones que han sidonecesarias para la convergencia y el cambio medio en los parámetros en cada una de ellas

( parameter abs change). Puede comprobarse como, efectivamente, esta convergencia se ha

producido en apenas 6 iteraciones y cómo, a partir de la tercera, los cambios han sidomínimos.

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 30/55

30

Cuadro 13.10 Historial de iteraciones

Al presentar los distintos índices de ajuste, hemos podido comprobar que en el modelo que

hemos tomado como ejemplo se ha obtenido un buen ajuste a los datos. Llegados a este

punto, vamos a analizar e interpretar los resultados que hemos mostrado.

13.6 INTERPRETACIÓN DEL MODELO

Hasta este momento nos hemos centrado en analizar la razonabilidad del modelo en términos

globales (su ajuste). Ahora vamos a examinar si los estimadores de los parámetros sontambién razonables en dos sentidos: (i) ¿toman valores adecuados teóricamente? y (ii) ¿son

significativos?.

La mayor parte de la información necesaria para esta fase, ya se ha mostrado en los cuadros

13.4, 13.5 y 13.6 y a ellos referiremos nuestros comentarios.

En primer lugar, vamos a analizar si los valores que toman los parámetros estimados son o no

compatibles con el modelo estadístico. Para que exista tal compatibilidad las respuestas a lassiguientes preguntas deben ser en todos casos negativas:

• ¿Existen correlaciones superiores a la unidad?

• ¿Existen cargas factoriales estandarizadas fuera del intervalo –1,+1?

• ¿Son los residuos estandarizados anormalmente grandes o pequeños?

• ¿Hay estimaciones negativas de las varianzas?

Si hubiera respuestas no negativas, y aunque el ajuste global del modelo fuera óptimo,

estaríamos ante un indicador claro de que (Long, 1983) esta incompatibilidad puede haberseoriginado por uno o más de los siguientes motivos:

1. El modelo está mal especificado.2. Los datos no respaldan la hipótesis de normalidad multivariante de las variables

observadas3. La muestra es demasiado pequeña

4. El modelo está demasiado cerca de no estar identificado, lo que hace la estimación de

algunos parámetros difícil o inestable.5. Los valores perdidos de algunas variables observadas han provocado que cada

elemento de la matriz de covarianzas muestral esté calculado sobre una muestradiferente.

ITERATIVE SUMMARY

PARAMETER

ITERATION ABS CHANGE ALPHA FUNCTION

1 0.298689 1.00000 0.88599

2 0.124292 1.00000 0.10692

3 0.026794 1.00000 0.03287

4 0.008439 1.00000 0.03231

5 0.001469 1.00000 0.03227

6 0.000443 1.00000 0.03227

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 31/55

31

Si se revisan los cuadros 13.4 a 13.6 se puede comprobar que, en el modelo del ejemplo, no se presenta ninguna de las incompatibilidades señaladas.

La segunda cuestión que debemos examinar es la significatividad estadística de cada

parámetro individual. Centraremos la explicación en los coeficientes de regresión entrevariables observadas y factores comunes, aunque lo expuesto es válido para el resto de parámetros (varianzas y covarianzas).

Si tomamos, por ejemplo, la segunda ecuación del cuadro 13.4, comprobamos que aparecen

las tres líneas que están reproducidas en el cuadro 13.11. La primera de ellas ofrece laecuación correspondiente a la variable observada “calificación en Filosofía” (FSF o V2). Esta

ecuación se expresa como una combinación lineal del factor común “inteligencia verbal” (F1)

multiplicado por el coeficiente de regresión estimado (0,509) y un error de medida (E2).

Cuadro 13.11 Ecuación con errores estándar y estadístico t

En la segunda línea aparece el error estándar (0,068) y el estadístico t (coeficiente/error

estándar = 7.467) que permite contrastar la hipótesis nula de que el parámetro es nulo.

Aunque la significatividad depende de los grados de libertad, para una muestra de un tamaño

mayor de 60, valores superiores a ± 1,96 permiten rechazar dicha hipótesis nula para un nivel

de significación α ≤ 0,05, o superiores a 2,56 para α ≤ 0,01. La carga factorial (o coeficiente

de regresión) es, pues, significativa en este caso, así como en el resto de los coeficientes queaparecen en el cuadro 13.4.

Es habitual ofrecer, sobre todo en la publicación de los resultados, la solución estandarizada

del AFC, esto es, aquella en que se recalculan los estimadores para asegurar que las varianzasde los factores comunes y de las variables observadas son igual a la unidad. Esto se hace,

básicamente, para facilitar la comparación de los resultados con trabajos precedentes. Estainformación, tal como la proporciona el EQS, se recoge en el cuadro 13.12 para las

ecuaciones fundamentales (estimación de las coeficientes de regresión de los factores

comunes y de los factores específicos), y las correlaciones entre los factores comunes.

FSF =V2 = .509*F1 + 1.000 E2

.068

7.467

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 32/55

32

Cuadro 13.12 Solución estandarizada

Esta información se suele presentar gráficamente tal y como se recoge en la figura 13.5.

Figura 13.5 Modelo AFC estimado

x1 x2 x3 x4 x5 x6

δ1

ξ1 ξ2

δ2

δ3

δ4

δ5

δ6

0,582

0,732 0,688 0,492 0,759 0,760 0,615

0,682 0,725 0,871 0,651 0,650 0,789

STANDARDIZED SOLUTION:

L =V1 = .732 F1 + .682 E1

FSF =V2 = .688*F1 + .725 E2

H =V3 = .492*F1 + .871 E3

M =V4 = .759 F2 + .651 E4

FSC =V5 = .760*F2 + .650 E5

Q =V6 = .615*F2 + .789 E6

CORRELATIONS AMONG INDEPENDENT VARIABLES

---------------------------------------

V F

--- ---

I F2 - IQ .582*I

I F1 - IV I

I I

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 33/55

33

13.7 REESPECIFICACIÓN DEL MODELO

Como señala Ullman (1996), existen básicamente dos motivos para reespecificar un modelo

(esto es, eliminar o introducir relaciones entre las variables que los conforman): (i) mejorar su

ajuste o (ii) contrastar alguna hipótesis teórica. Existen, sin embargo, muchos problemas que pueden generarse como consecuencia de una reespecificación poco meditada. Como veremosa continuación, existen dos instrumentos analíticos –el contraste del multiplicador de

Lagrange y el contraste de Wald– que nos indican qué relaciones causales pueden añadirse oeliminarse y qué mejoras en el ajuste obtendríamos con cada una de esta modificaciones. Si el

investigador cae en la tentación de ir incorporando o eliminando relaciones sin más, hastalograr un ajuste razonable y no tiene en cuenta si estas modificaciones están o no soportadas

por el marco teórico que sustenta su investigación, puede provocarse que el modelo al que se

llega no sea en absoluto generalizable (McCallumn, Roznowski y Necowitz, 1992).

En este mismo sentido, Pedhazur (1982) y Sorbom (1989) afirman que es científicamente

incorrecto modificar un modelo simplemente porque mejore su ajuste, ya que el cambio debeser teóricamente interpretable y el investigador debe ser capaz de justificar cuál es el motivo

para añadir una relación causal determinada.

Todo lo expuesto lleva a Hatcher (1994) a plantear las siguientes recomendaciones para lamodificación de un modelo, aunque la mayoría se basan en el trabajo de McCallumn,

Roznowski y Necowitz (1992):

1. Utilizar muestras grandes. Los modelos basados en menos de 100 o 150 casos llevan

a modelos finales poco estables si las modificaciones se basan en los datos y no en lateoría.

2.

Hacer pocas modificaciones. Es posible que las primeras modificaciones puedan estar

derivadas de un modelo que refleje las relaciones poblacionales; las siguientes, probablemente, reflejarán relaciones específicas de la muestra.

3. Realizar solo aquellos cambios que puedan ser interpretados desde una perspectivateórica o tengan soporte en trabajos precedentes. En todo caso, se deben detallar todos

los cambios realizados sobre el modelo inicial en el informe del trabajo final.

4. Seguir un procedimiento paralelo de especificación. Siempre que sea posible, elinvestigador debería trabajar con dos muestras independientes. Si las dos muestras

desembocan en las mismas modificaciones del modelo, se podrá tener una mayorconfianza en la estabilidad del mismo.

5.

Comparar modelos alternativos desde el principio. Más que proponer un modelo e irmodificándolo, puede ser conveniente en algunas ocasiones plantear modelosalternativos y determinar con cuál se obtiene un mejor ajuste.

6. Finalmente, describir detalladamente las limitaciones de su estudio. Como indicaHatcher (1994), la mayoría de los trabajos que se publican están basados en una única

muestra y sobre los que se efectúan sucesivas modificaciones basadas en los datos

hasta lograr un ajuste razonable. Si se sigue este enfoque, sería recomendable que eltrabajo advirtiera al lector de todas estas circunstancias.

Una vez planteadas estas precauciones, veamos a continuación los instrumentos de que sedispone para reespecificar un modelo.

8/20/2019 Análisis factorial confirmatorio.pdf

http://slidepdf.com/reader/full/analisis-factorial-confirmatoriopdf 34/55

34

13.7.1 Significatividad de los parámetros

La primera modificación posible, y la más obvia, para mejorar el ajuste de un modelo es

eliminar aquellos parámetros cuyos estimadores no sean significativos de acuerdo con los

resultados de contraste t . Aunque esta acción puede que no haga disminuir el valor de la χ 2, sí

que puede hacer aumentar la probabilidad de que no sea significativa gracias al aumento delvalor crítico para un nivel de significación determinado al eliminar grados de libertad (Long,1983).

En nuestro ejemplo, tal y como se comprueba en los cuadros 13.4, 13.5 y 13.6, todos loscoeficientes estimados son significativos

13.7.2 Contraste del multiplicador de Lagrange

El contraste ML permite evaluar la mejora que se obtiene al añadir una relación causal o una

nueva covarianza al modelo teórico. Para determinar si esta mejora es estadísticamentesignificativa, el estadístico lleva asociado un nivel de significación.

El EQS ofrece dos versiones de este contraste, la univariante y la multivariante. En la