INTRODUCCION Cadenas de Markov

-

Upload

christian-fernando-luicho-t -

Category

Documents

-

view

18 -

download

11

description

Transcript of INTRODUCCION Cadenas de Markov

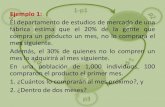

INTRODUCCION

En los negocios, las cadenas de Markov se han utilizado para analizar los patrones de compra, los deudores morosos, para planear las necesidades de personal y para analizar el reemplazo de equipo.Las cadenas de markov son procesos estocsticos en el que la probabilidad del estado futuro no depende de los estados anteriores si no depende del estado actual, es decir su comportamiento futuro no depende del pasado, dado el presente, el futuro es independiente del pasado.La presente investigacin ha girado en torno al cumplimiento de los siguientes objetivos: Definir que es un proceso estocstico y cadenas de markov Conocer ms a fondo la clasificacin de estados de cadenas de Markov Determinar los temas que estn relacionados respecto a las cadenas de MarkovEl presente trabajo est estructurado en: definiciones, ecuaciones, estados absorbentes, distribucin estacionaria, y ejemplos aplicativos sobre las cadenas de Markov.La metodologa empleada para la investigacin ha sido a travs de la recopilacin de referencias existentes sobre el tema tratado Cadenas de Markov