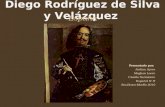

jessica muñoz velazquez

description

Transcript of jessica muñoz velazquez

La teoría de la información tiene sus orígenes

en un papel de 1948 por América el

ingeniero matemático Claudio Shannon: " la

teoría matemática de comunicación. " esta

teoría permite a la información en el

mensaje para ser cuantificado, por lo general

como bits de los datos que representan uno

de dos estados: prendido o apagado, esto

solamente dicta como codificar y transmitir

la información en la presencia de "ruido",

que puede corromper un mensaje en la ruta.

En el corazón de la teoría de Shannon es el

concepto de incertidumbre. Más

incertidumbre hay con respeto a lo que la

señales. Los más bits de información son

requeridos para hacer segura la información

esencial transmitida. Shannon llamó esta

duda a base de medida de información

entropía. Él matemáticamente demostró que

una señal podría ser codificada - redujo lo

más simple, así eliminando la interferencia o

el ruido - para transmitir un mensaje claro, y

sólo el mensaje. Aunque haya siempre una

posibilidad de error en la transmisión, el uso

de teoría de la información infinitamente

reduce al mínimo aquella posibilidad.

Vía codificación de teoría. Un vástago

importante de información sobre la teoría,

los ingenieros estudian las propiedades de

códigos para el objetivo de diseñar datos

eficientes, confiables por quitando la

redundancia y errores en los datos

transmitidos. Esto tiene dos características

primarias. La fuente de codificación

es un intento para comprimir los datos de

una fuente para transmitir los datos de una

Manera más eficiente (si usted no ha

descomprimido un archivo para enviarlo

alguien, usted ha visto la fuente de

codificación en acción). La codificación de

canal añade extra bits de datos

suplementarios para hacer la transmisión de

datos más resistente de alborotos sobre el

canal de transmisión.

Una consola que mezcla música electrónicamente se

combina, rutas, y cambia la dinámica de señales de audio.

EL PODER DE INFORMACION